前几天有个朋友在MSN里面问搜索引擎友好指的是什么,这是个涉及面挺宽的问题,今天从几方面谈一下大概。

假设我们从搜索引擎蜘蛛的角度去看待一个网页,在抓取,索引和排名的时候会遇到哪些问题呢?解决了这些问题的网站设计就是搜索引擎友好的。

搜索引擎蜘蛛能不能找到你的网页?

要让搜索引擎找到你的主页你就必须要有外部链接,在找到你的主页之后,还必须能找到你的更深的内容页,也就要求你要有良好的网站结构,符合逻辑,可能是一个扁平的,可能是一个树状的。

而且这些网页之间要有良好的链接结构,这些链接以文字链接最好,图像链接也可以,但是JavaScript链接,下拉菜单链接,flash链接等就会有问题。

一般推荐网站需要有一个网站地图,把所有重要的栏目和网页都列进去。如果网站比较大,网站地图还可以分成几个。

网站的所有页面都要能从主页开始,顺着链接找到,最好在3,4次点击之内。

搜索引擎蜘蛛找到网页后能不能抓取网页?

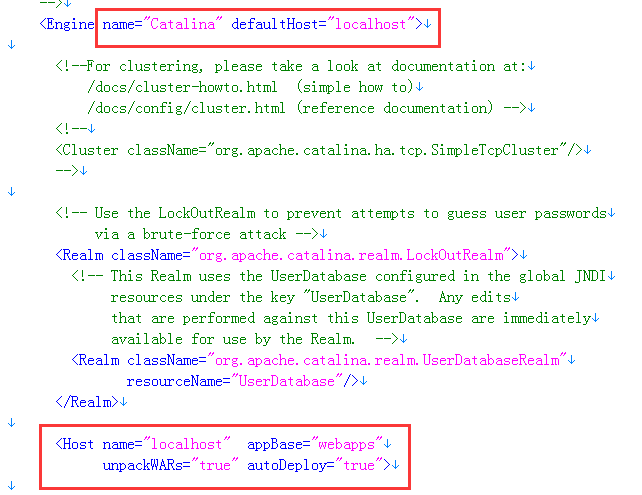

网页的URL必须是可以被抓取的,如果网页是由数据库动态生成的,那么URL一般要经过改写成静态的,也就是去掉那些URL中问号参数之类的东西, 也要去掉Session ID。技术上倒不是搜索引擎不能读取这种URL,但是为了避免陷入无限循环,搜索引擎蜘蛛通常要远离这类URL。

还有如果你的网站是一个整个的flash,那也没办法读取。虽然搜索引擎在努力想读取flash信息,但目前为止收效甚微。

还有框架结构(frame),在网站刚出现的时候,框架结构风行一时,现在还有不少网站在用,这是搜索引擎蜘蛛的大敌。有的时候可以抓取,但别自找麻烦。

还有尽量去除不必要的搜索引擎不能读的东西,像音频文件,图片,弹出窗口等。

搜索引擎蜘蛛抓取网页之后,怎样提炼有用信息?

网页的HTML码必须很优化,也就是格式标签占的越少越好,真正内容占的越多越好,整个文件越小越好。把CSS,JavaScript等放在外部文件。

把关键词放在应该出现的地方。

检查网页对不同操作系统,不同browser的兼容性。检查是否符合W3C标准。

只有搜索引擎能顺利找到你的所有网页,抓取这些网页并取出其中真正的有相关性的内容,这个网站才可以被视为是搜索引擎友好的。

55 0

上一篇 关于网络关键字(排名用)